在 Dify 中配置 self-hosted vllm 模型

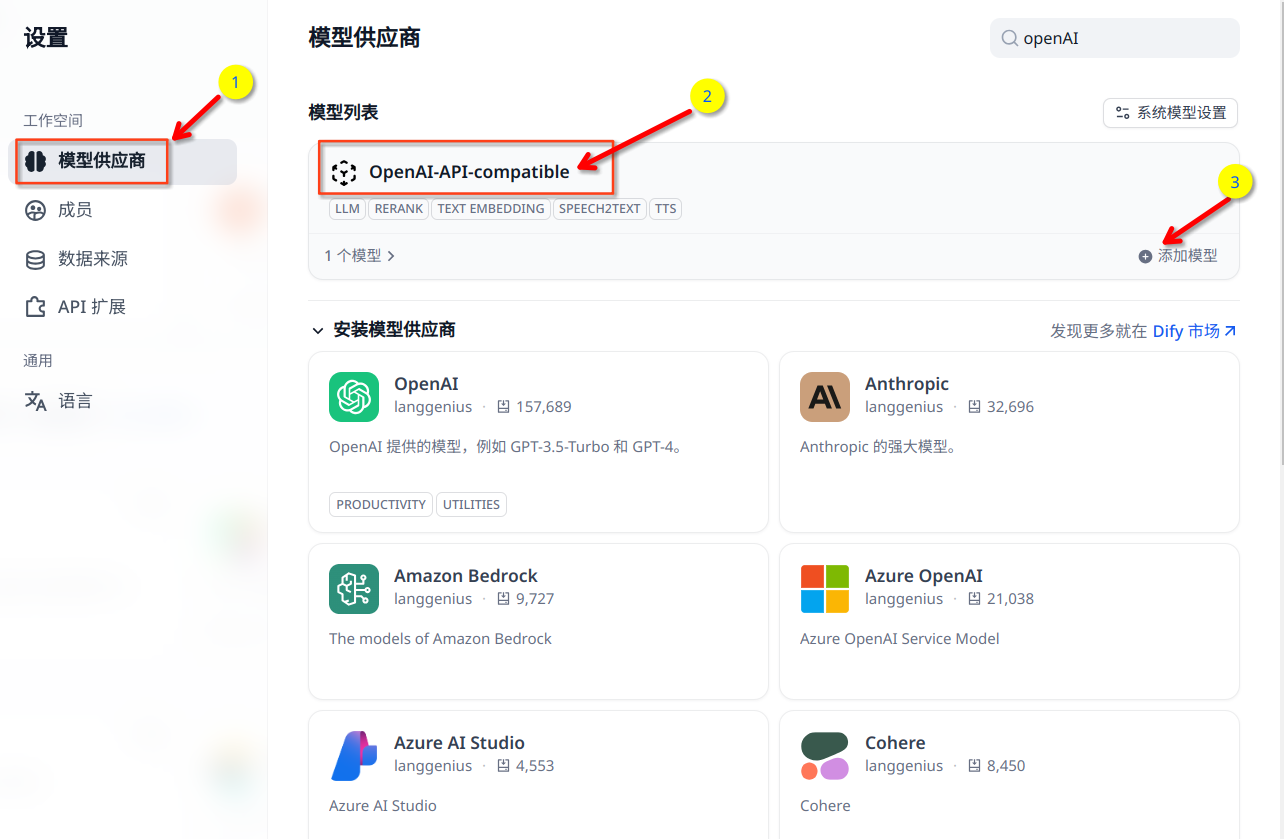

在 Dify 中配置 self-hosted vllm 模型 作为模型供应商时,应选择 OpenAI-API-compatible

self-hosted vllm 模型安装可以参考我的文章 如何使用 vLLM 部署千问 3 大语言模型?

点击头像=>设置=>模型供应商=> 搜索 OpenAI-API-compatible => 鼠标滑动到模型会出现安装按钮 => 点击安装

然后点击添加模型

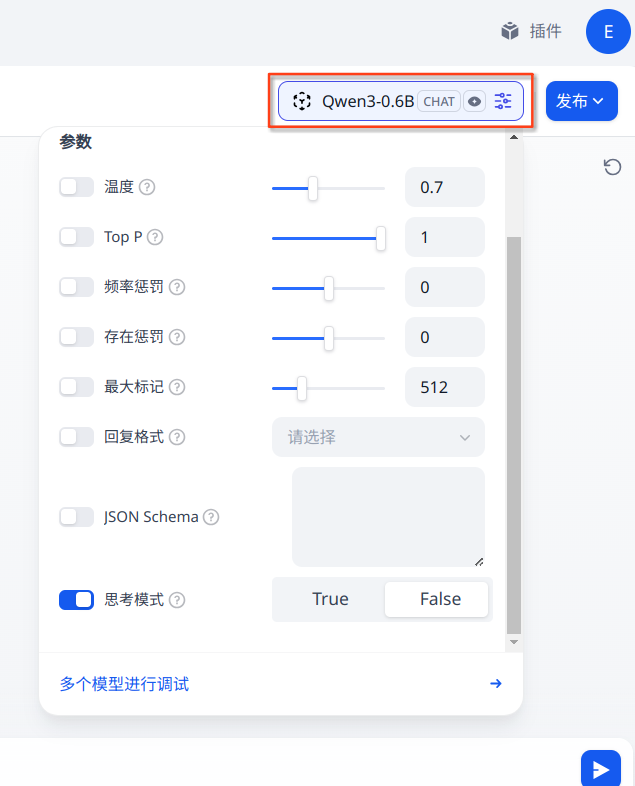

模型类型选择:LLM

模型名称: 例如 Qwen3-0.6B

API Key: 不会实际使用到,可以随便输入一个 key, 例如 xxx

API endpoint URL: http://your_server_ip:8000/v1

然后点击保存,保存成功会有提示。

然后回到 主页=> 工作室 => 选择自己的App, 在模型列表里面就会出现刚刚配置的模型了,如下图

在 Dify 中配置 self-hosted vllm 模型